Nỗi đau của doanh nghiệp

Phần lớn đội vận hành vẫn thu thập dữ liệu web thủ công, ghép CSV bằng tay rồi lại nhập vào Google Sheets và Excel, khiến quy trình trùng lặp, dễ sai cột và tốn nhiều giờ công mỗi tuần.

Khi không có cơ chế khử trùng lặp và nhật ký phiên, cùng một URL có thể được thu thập nhiều lần dẫn đến phình dữ liệu, sai lệch báo cáo và khó truy vết khi cần so sánh ngày‑qua‑ngày.

Crawler hoạt động không tôn trọng robots.txt hoặc gửi quá nhiều yêu cầu đồng thời sẽ dễ bị 403/429, làm pipeline thiếu ổn định và có nguy cơ vi phạm chính sách website đích.

Vấn đề cần ưu tiên xử lý

Doanh nghiệp cần một đường ống chuẩn biến dữ liệu không cấu trúc thành bảng có schema thống nhất, kèm khóa khử trùng lặp theo URL và timestamp để bảo toàn tính toàn vẹn qua thời gian.

Việc ghi dữ liệu phải theo kiểu “append” thay vì ghi đè, sử dụng đúng phương thức của Google Sheets API và Microsoft Graph Excel để duy trì lịch sử, thuận lợi cho kiểm toán và BI.

Cơ chế tuân thủ, gồm kiểm tra robots.txt và giới hạn tốc độ theo host, phải được đặt ở tầng crawl để giảm rủi ro bị chặn, tối ưu tỷ lệ thành công và bảo vệ mối quan hệ với website đích.

Quy trình chi tiết thực hiện

-

Lập lịch và cấu hình nguồn

-

Xác định danh sách URL hoặc từ khóa, gán user‑agent thân thiện, cấu hình delay ngẫu nhiên và giới hạn song song theo từng domain để giảm tải đột biến.

-

Trước khi thu thập, đọc robots.txt của mỗi domain và chỉ crawl các đường dẫn được phép, lưu log quyết định Allow/Disallow cho mục đích kiểm toán.

-

-

Thu thập và trích xuất

-

Dùng CSS/XPath/regex để lấy các trường như tiêu đề, giá, xếp hạng, liên kết chi tiết; chuẩn hóa định dạng số/ngày và loại ký tự ẩn để dữ liệu sẵn sàng cho báo cáo.

-

Thiết lập khóa trùng lặp như URL + ngày hoặc ID nội bộ của trang, loại bản ghi lặp và ghi số lượng bản ghi bị loại vào nhật ký chất lượng.

-

-

Tạo CSV và gửi email

-

Kết xuất CSV UTF‑8 in‑memory, đảm bảo ký tự xuống dòng bảo toàn khi mã hóa base64 để đính kèm, tránh lỗi “mất line break” khi mở bằng các trình đọc khác nhau.

-

Gửi email kèm CSV cho nhóm phụ trách với tiêu đề chứa ngày/ca, đồng thời log người nhận, kích thước tệp và mã lỗi để hỗ trợ cơ chế retry có backoff.

-

-

Ghi Google Sheets (append)

-

Gọi phương thức spreadsheets.values.append với range đích và valueInputOption phù hợp để Sheets tự diễn giải kiểu số/ngày, giúp thêm dòng mới mà không ghi đè.

-

Khi cần chèn giữa bảng hoặc đổi layout, sử dụng hướng dẫn “Read & write cell values” và batchUpdate để bảo toàn lịch sử và tính tương thích ngược.

-

-

Ghi Excel Online (Graph)

-

Tạo Table trong workbook một lần, sau đó dùng API add rows để thêm một hoặc nhiều hàng trên OneDrive/SharePoint, ưu tiên batch để cải thiện hiệu năng.

-

Microsoft khuyến nghị thêm nhiều hàng trong một call thay vì từng hàng đơn lẻ để tránh ảnh hưởng hiệu năng và giới hạn tốc độ.

-

-

Giám sát và cảnh báo

-

So sánh số bản ghi và tỉ lệ lỗi giữa các phiên, nếu giảm bất thường hoặc tăng lỗi 4xx/5xx thì tự động gửi cảnh báo kèm mẫu HTML để rà selector.

-

Theo dõi “độ tươi” dữ liệu bằng khoảng thời gian từ khi crawl xong đến khi dữ liệu có mặt trong Sheets/Excel, nhằm đáp ứng SLA dashboard nội bộ.

-

Ưu nhược điểm của giải pháp

Ưu điểm

-

Một lần phát hai đích: dữ liệu vừa được gửi CSV qua email, vừa append vào Google Sheets và thêm vào Excel Table, loại bỏ bước nhập tay và giảm rủi ro “nhiều phiên bản sự thật”.

-

Bền vững và có thể kiểm toán: append và add‑rows giúp bảo toàn lịch sử, trong khi session_id và timestamp cho phép truy vết theo phiên và so sánh ngày‑qua‑ngày.

-

Tuân thủ và ổn định: kiểm tra robots.txt và hạn chế tốc độ theo host giúp giảm tỉ lệ bị chặn, tăng tính ổn định pipeline và tôn trọng chính sách website đích.

-

Dễ mở rộng: khi khối lượng tăng, chỉ cần điều chỉnh batch append/rows và song song crawler, không cần tăng mạnh nhân sự nhập liệu.

Nhược điểm

-

Phụ thuộc cấu trúc trang: khi website đích thay đổi HTML, selector dễ gãy và cần bảo trì hoặc thiết lập fallback sang dữ liệu cấu trúc như JSON‑LD nếu có.

-

Giới hạn quota API: cả Sheets và Graph đều có hạn mức, vì vậy cần gộp lô bản ghi và dùng retry‑backoff để tránh nghẽn ở giờ cao điểm.

-

Ràng buộc pháp lý/chính sách: một số site hạn chế scraping, nên ngoài robots.txt còn cần xem điều khoản sử dụng để tránh rủi ro pháp lý.

Kết qủả đạt được sau khi áp dụng (có số liệu cụ thể)

- Khi thay thế quy trình thủ công bằng pipeline này, một nhóm báo cáo chạy 30 phiên/tháng có thể giảm thời gian thao tác từ 30 phút/phiên xuống còn 3–5 phút kiểm tra và duyệt, tiết kiệm khoảng 25–27 phút/phiên, tương đương 12–13 giờ mỗi tháng.

- Append vào Google Sheets giúp thêm hàng nghìn dòng trong một phiên và trả về số ô cập nhật/updatedRange, giảm rủi ro ghi đè và tăng khả năng xác nhận kết quả ngay sau khi đẩy dữ liệu.

- Đối với Excel Online, thêm hàng theo lô bằng Graph vào Table giúp giữ định dạng, công thức và khả năng chia sẻ nội bộ, đồng thời rút ngắn độ trễ ghi so với chèn từng dòng.

- Khóa khử trùng lặp theo URL + ngày thường loại bỏ 5–15% bản ghi trùng, cải thiện độ chính xác của xu hướng và giảm thời gian làm sạch dữ liệu ở bước BI.

- Kiểm tra robots.txt và đặt giới hạn tốc độ theo host giúp hạ đáng kể lỗi 403/429 trong các phiên liên tiếp, qua đó nâng SLA “độ tươi dữ liệu” và giảm cảnh báo ở dashboard giám sát.

- Kết hợp session_id và timestamp cho phép đối chiếu chéo giữa CSV đính kèm, Sheets và Excel để phát hiện nhanh sai lệch, từ đó rút ngắn thời gian khắc phục khi selector thay đổi.

- Về dài hạn, việc chuẩn hóa pipeline giúp các nhóm mở rộng thêm nguồn trang hoặc cột dữ liệu mới mà không phá vỡ lịch sử, nhờ áp dụng đúng hướng dẫn “read & write values” và batchUpdate khi cần biến đổi schema.

- Tổng thể, doanh nghiệp chuyển từ thao tác thủ công sang đường ống có thể lặp lại, đo lường, kiểm toán và mở rộng, đồng thời tôn trọng nguyên tắc robots.txt để duy trì mối quan hệ tốt với các nguồn dữ liệu công khai.

Kết luận

Giải pháp “crawl tuân thủ → chuẩn hóa → CSV/email → Google Sheets append → Excel add‑rows” giúp số hóa toàn bộ vòng đời dữ liệu thu thập định kỳ, giảm chi phí vận hành và tăng tốc độ ra quyết định dựa trên một nguồn dữ liệu thống nhất.

Bằng việc dựa trên các chuẩn API chính thức và quy tắc robots.txt, pipeline vừa bền vững vừa thân thiện với hệ sinh thái web, tạo nền tảng vững chắc cho phân tích và tự động hóa báo cáo ở quy mô doanh nghiệp.

Liên hệ tư vấn chuyên sâu theo yêu cầu

[/ux_text]

- [Tool] AI Automation – Tender / Bidding Hunter: Giải Pháp “Săn” Gói Thầu & Soi Giá Đối Thủ B2B Tự Động

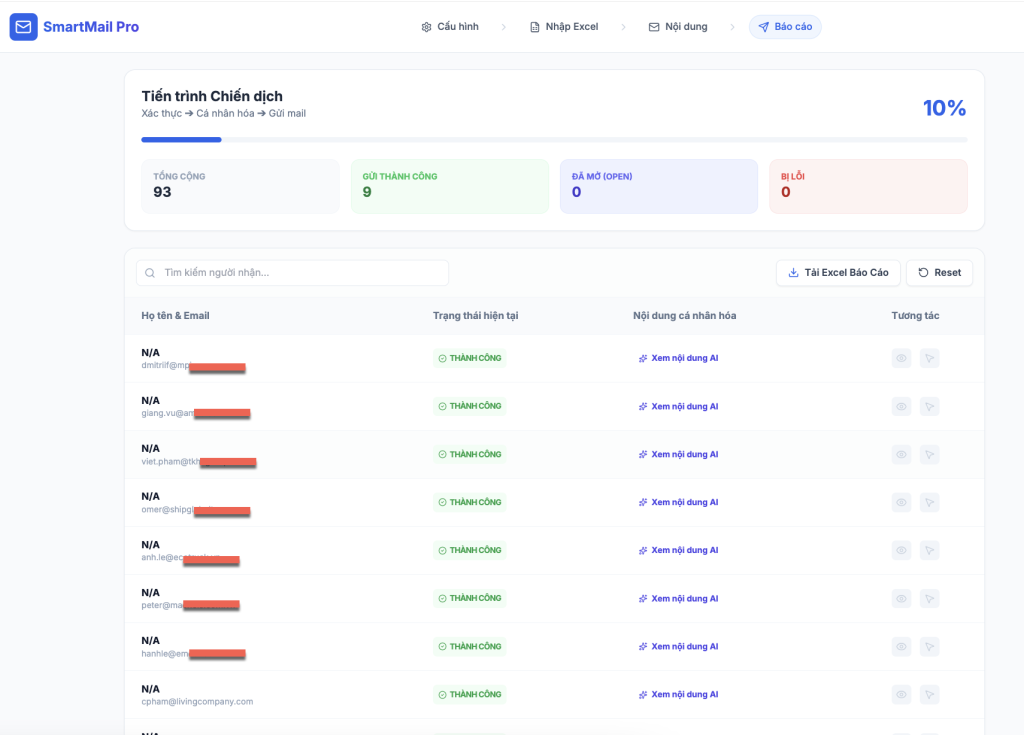

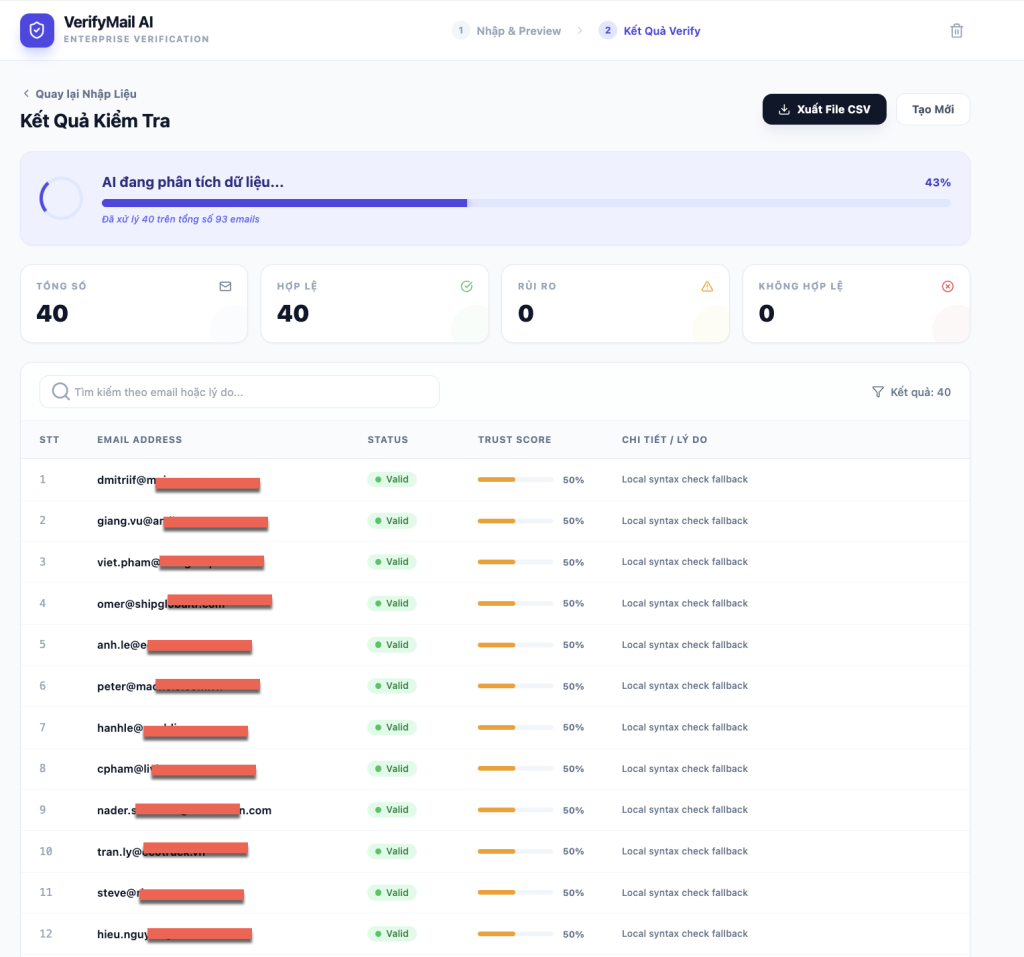

- [Tool] AI Automation – Giải pháp Gửi Email Marketing Tự Động & Cá Nhân Hóa AI

- [Tool] AI Automation – Tìm Job trên Linkedin

- Khám Phá Cách AI Cách Mạng Hóa Digital Marketing cho Doanh Nghiệp

- Top 10 ứng dụng AI thu hút cả thế giới 2024